Google開発のLLMであるPaLMについて解説!PaLM2が生成AIのBardに搭載!

こんにちは!

データサイエンティストのウマたん(@statistics1012)です!

各社AIブームにおける覇権争いを繰り広げていますが、その中でもこの記事ではGoogleが開発・リリースした大規模言語モデルのPaLMについて解説していきたいと思います!

以下のYoutube動画でも解説しているので是非あわせて参考にしてみてください!

目次

PaLMの仕組みや構成

PaLMは2022年にGoogleから発表されたモデルで「Pathways Language Model」の略です。

論文は以下になります。

論文はなんと87ページにも及ぶ超大作なのですが、正直特別革新的なアーキテクチャが登場するわけではなく、ベースとなるのはやはり2017年に同じくGoogleが発表したTransformerというアーキテクチャです。

PaLMとは端的に言うと、「とにかく大量のパラメータを持ったモデルで大量のデータを最強のマシン構成で学習させたようなモデル」なのです!

5400億個のパラメータ

まずは、パラメータの数。

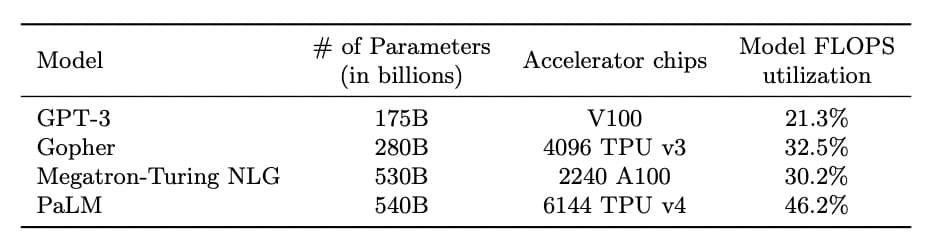

PaLMよりも前に発表されたOpenAIのGPT-3のパラメータが1700億個。

そしてMicrosoftから発表されたMegatron-Turing NLGのパラメータが5300億個。

Megatron-Turing NLGも絶妙に100億個パラメータが多いところがGoogleの意地を感じます。

ちゃんと論文には、ご丁寧に他の大規模言語モデル(LLM)と比較してどれだけPaLMがどれだけスゴイのかが記載されています。

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

7800億個のトークン

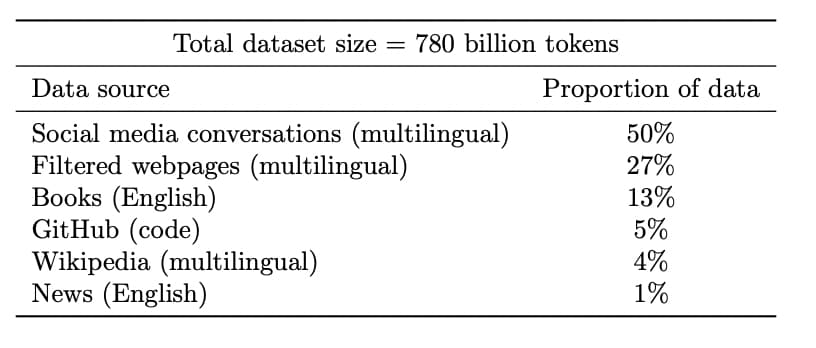

続いて学習に使ったのは7800億個のトークンであると言っています。

英語だと1単語が1トークンにあたるイメージです。

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

内訳としては、ソーシャルメディアの会話データが50%を占めていて、Webサイトや本やGithubやWikipediaなどの情報が並びます。

書籍とニュースに関しては英語オンリーであり、他の情報も多言語といいつつ英語の割合が大きいはずなのでどうしても英語の精度が高くなってしまうのは必然でしょう!

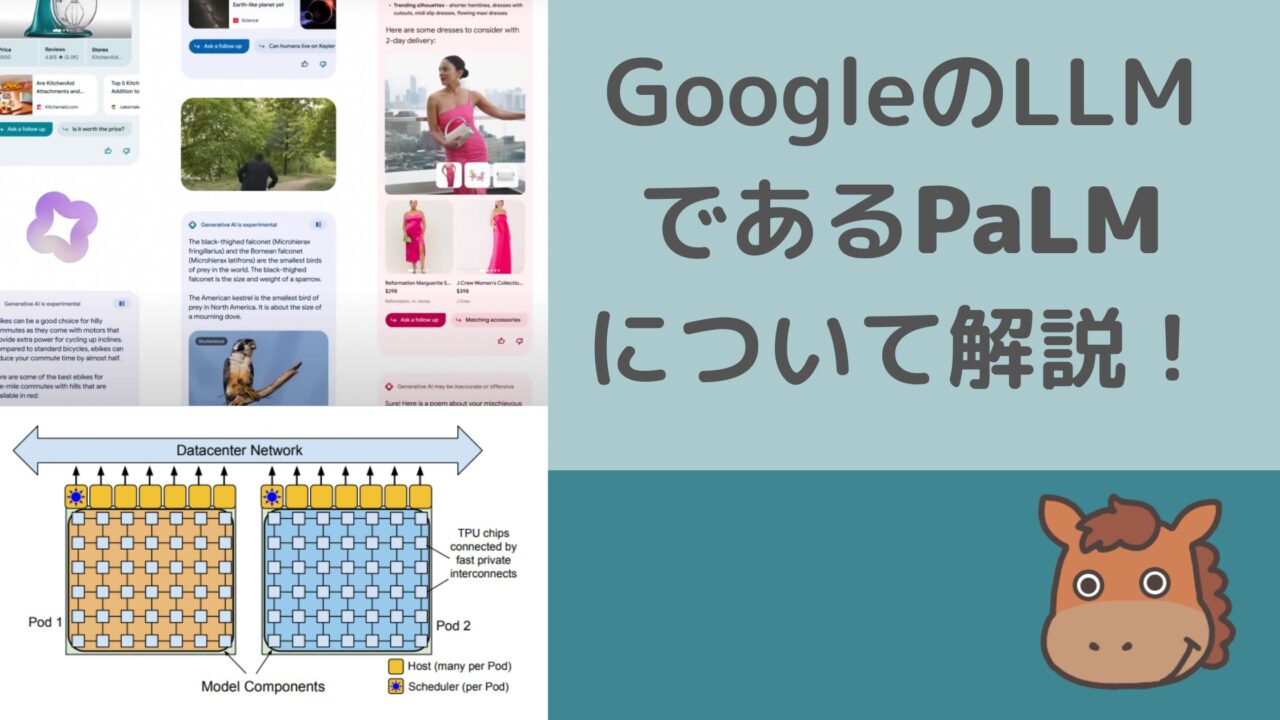

最強のマシン構成と学習の効率化

そして、大量のパラメータで大量の学習データを学習させるためにはそれなりのマシンパワーが必要です。

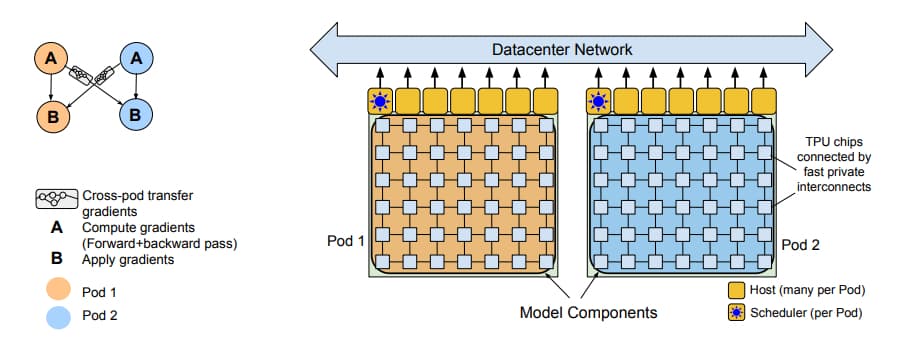

そこで用いられたのが6144台のTPU V4。TPUとは「Tensor Processing Unit」の略でありGoogleが開発した深層学習のためのプロセッサーです。

TPU1台でもスゴイのにそれを6144台も使用して学習しています。

これまでのGoogleが学習に使用した構成としては最大規模になります。

そしてこの学習にはPaLMの名称由来にもなっているPathwaysという学習アプローチが用いられているようで、2つのTPUポッド(複数のTPUが集まったもの)を使って並行学習をしていくような構成になっているっぽいです。

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

これにより大量のマシンパワーで学習効率を上げて学習しているんですね。

PaLMの出来ること・評価

ここまででPaLMの構成について簡単に解説してきましたが、続いてそんなPaLMの出来ることや性能評価について見ていきましょう!

一般性能評価

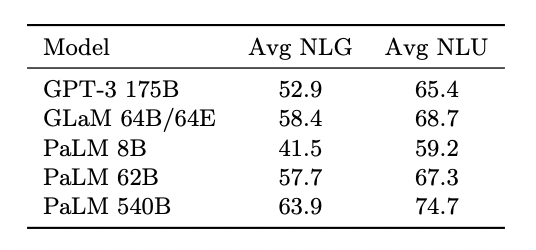

以下のようにGPT-3のモデルと比較しても各指標の精度が高いことが分かります。

(出典:「Scaling Language Modeling with Pathways」)

NLG(Natural Language Generation)は言語生成精度、NLU(Natural Language Understanding)は言語理解精度を表しています!

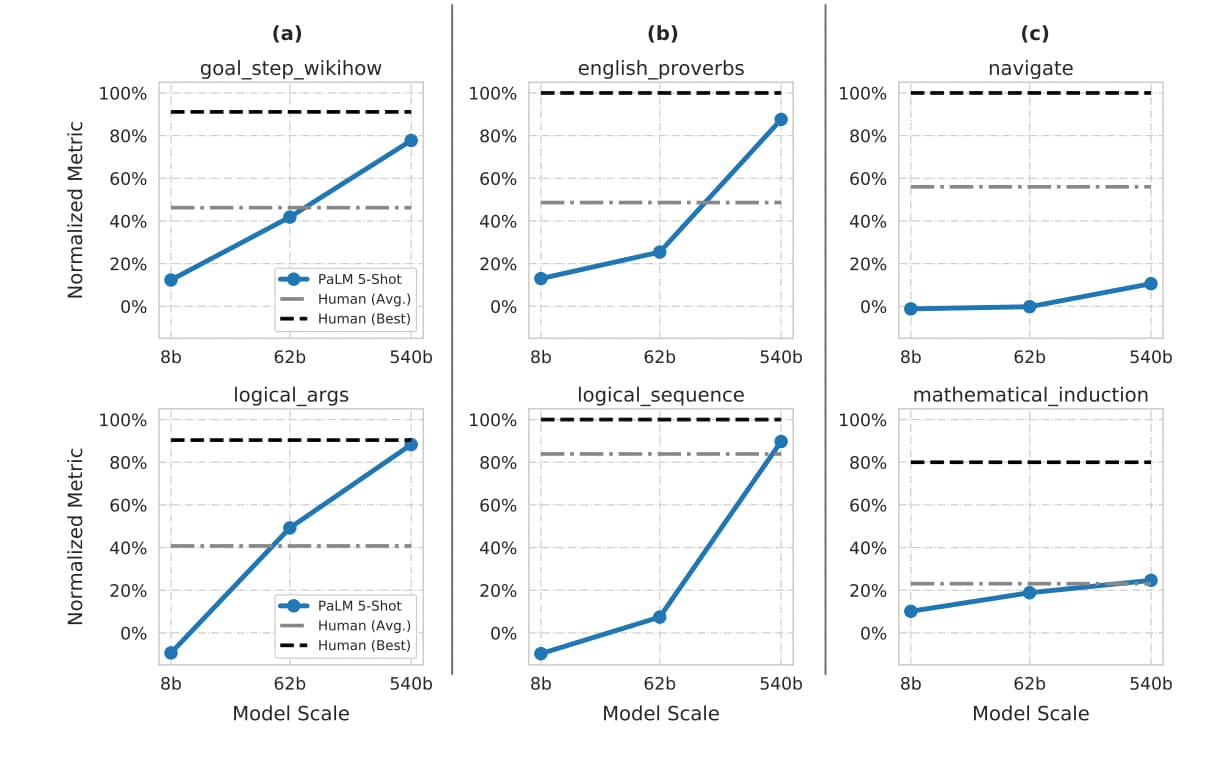

また、以下を見ていただくと「english_proverbs」や「logical_sequence」ではパラメータを増やすことで劇的に精度が向上していることが伺えます。

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

物理の世界で存在する量を増やしていくとある臨界点を超えたタイミングでいきなり質が向上するという現象が昨今のAI領域では散見されるのです。

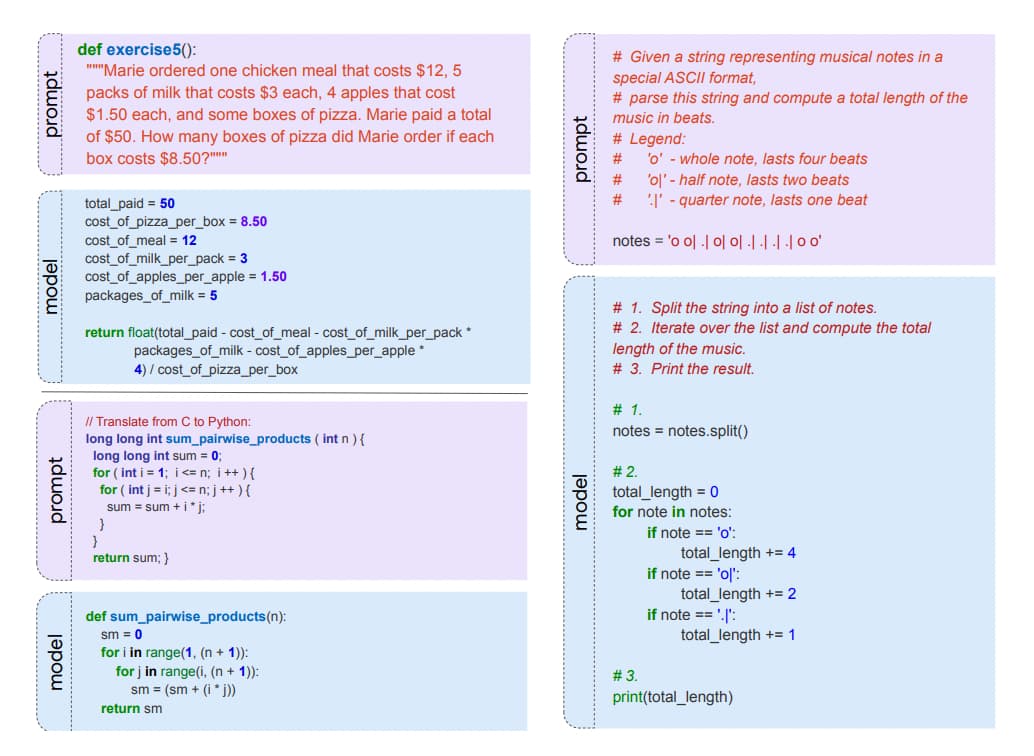

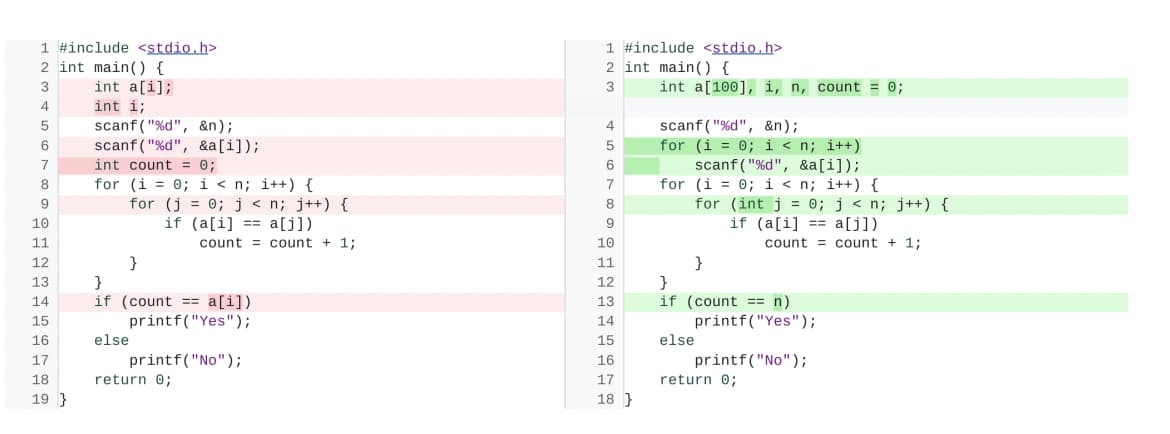

コード修正ができる

PaLMでは指示に対してコードの生成やコードのバグ修正も簡単に可能です。

Githubのコードデータが全体の5%ですが、ちゃんとコーディングルールを学習しています。

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

やはりコード生成やコードのバグ修正などは、大規模言語モデル(LLM)の得意分野ですね!

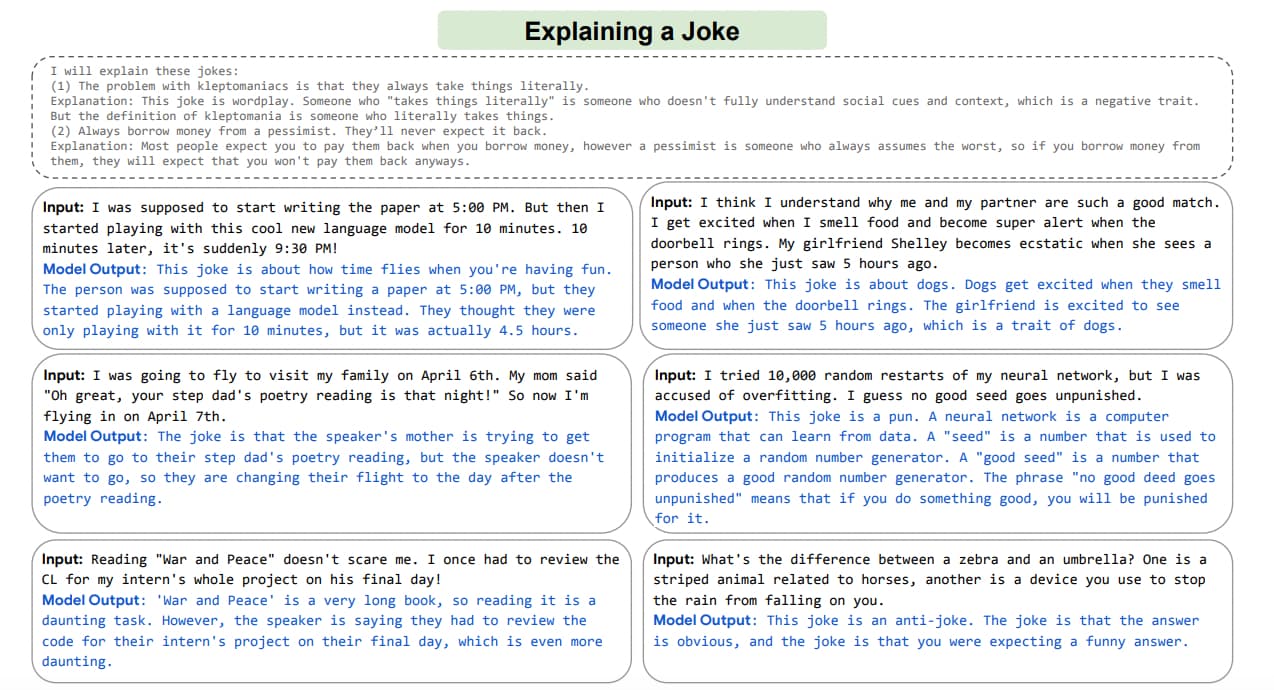

ジョークの理解

ジョークの理解なども分かりやすいものであれば出来てしまいます。

(出典:「Scaling Language Modeling with Pathways」)

(出典:「Scaling Language Modeling with Pathways」)

そしてPaLMからPaLM2

そしてPaLMからさらに進化したPaLM2が2023年5月11日に発表されました。

Googleからの公式リリースは以下になります。

PaLM2に関して明らかになっていることは少ないですが、簡単に見ていきましょう!

PaLM2はどんなモデル?

PaLM2に関しての論文は現時点(2023年5月時点)では発表されていないのですが、先ほど紹介したGoogleの公式サイトに以下の通り記載があります。

PaLM 2 は、この研究を発展させたもので、多言語、推論、およびコーディング機能が向上した最先端の言語モデルです。

この研究というのはまさにPaLMの研究であり、おそらくアーキテクチャ上の革新的な進化はないものの、モデルのパラメータを増やし、学習データセットの質・量を増やし、人間のフィードバックによるファインチューニングをかけることなどにより、精度を向上させたことが伺えます。

Googleは以下のようにも述べています。

AI の開発における過去 10 年間に、私たちはニューラルネットワークを大規模化することで非常に多くのことが可能になることを学びました。~ 中略 ~

モデルのアーキテクチャと学習方法に関する最近の進歩の過程で、マルチモーダル性を獲得させる方法、人間からのフィードバックをプロセスに含めることの重要性、モデルをこれまで以上に効率的に構築する方法などが分かりました。これらはどれも有用な技術要素であり、AI の最新技術を進歩させ、人々の日常生活に真の利益をもたらすモデルを構築していくために役立ちます。

これまでAI開発のトップを走ってきたGoogleですが、Googleが2017年に発表したTransformerを皮切りに各社資本力を使ったAI開発合戦に突入し、今ではOpenAI×Microsoft連合軍にその地位を脅かされています。

これからの動向に目が離せません!

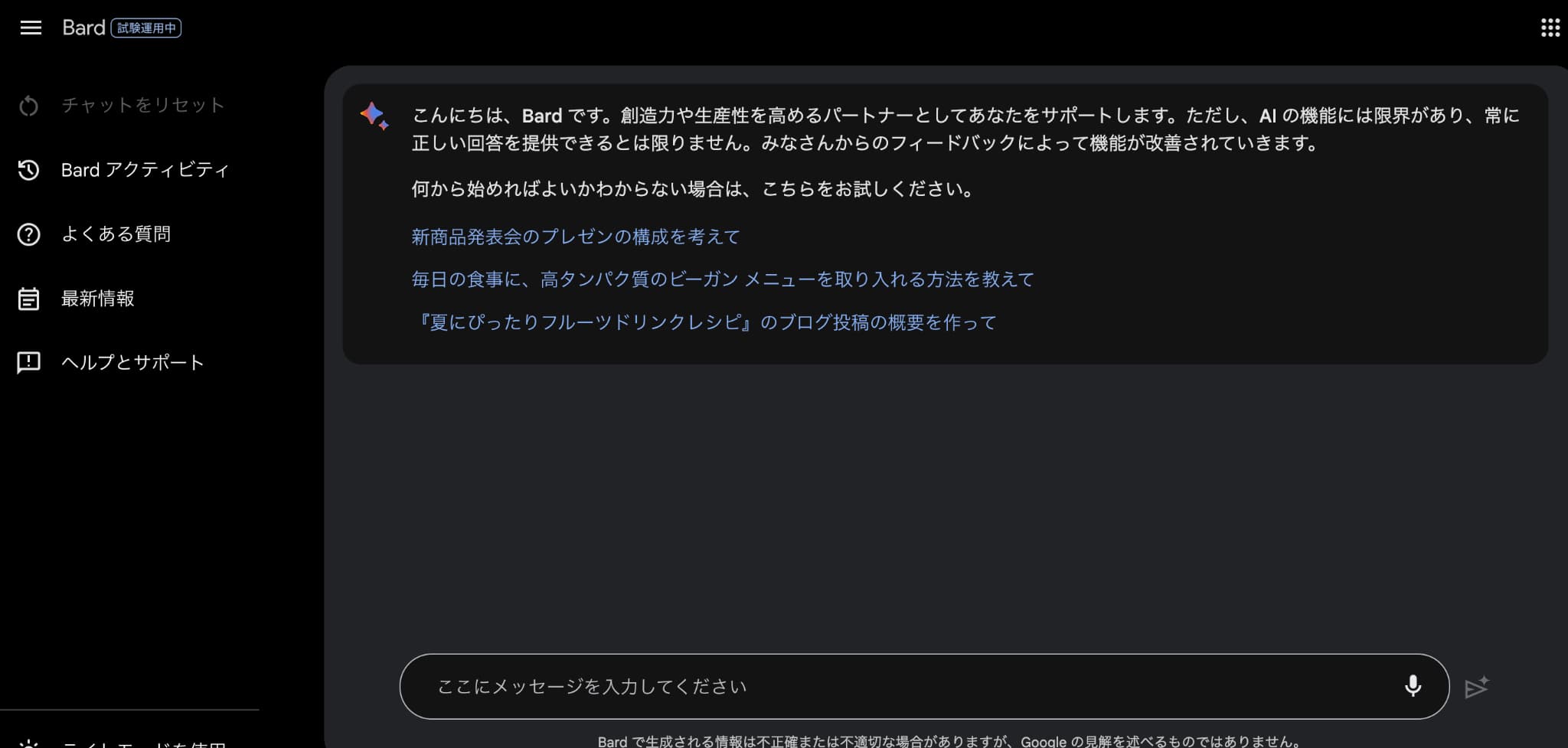

Bardへの搭載

また、BardというGoogleが開発している対話型AIサービスにもPaLM2が搭載されています。

そしてPaLM2の搭載と同時に今まで英語対応だけだったBardが日本語を含む多言語対応化され、そしてウェイトリスト方式だったのが登録さえすれば全ユーザーが使える方式に変わりました。

Googleも本腰を入れて、このChatGPTが巻き起こした対話型AIブームのシェア獲得に乗り出してきています。

開発者向けのPaLM APIの提供

またPaLM2の発表と同時に開発者向けにPaLM APIの提供もはじまりました。

こちらはまだウェイトリスト方式で全てのユーザーが利用できるわけではないようです。

PaLM2などの大規模言語モデルをベースにした生成系AIを活用した検索エンジンの運用

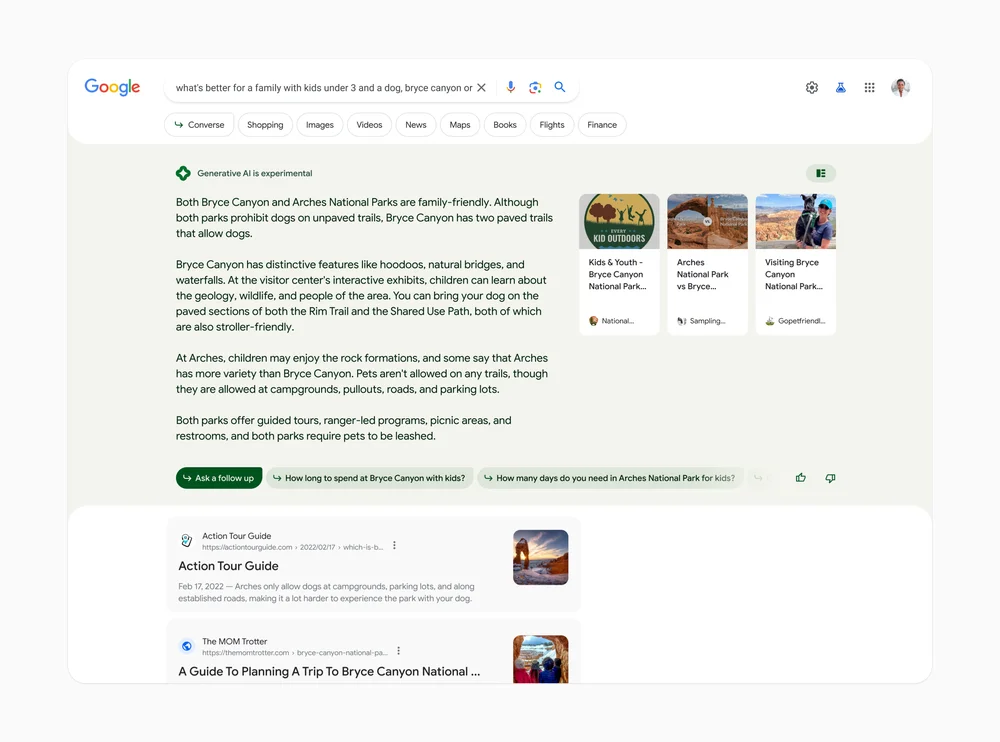

また、検索エンジンへのPaLM2などの大規模言語モデルの利用も試験的にはじめるとアナウンスを出しました。

以下のGoogle発表のデモを見ていただくと分かるのですが、これによりSEO領域は大きく変わりそうな予感がします。

以下のようにGoogle検索した結果に対してWebページが表示されるのではなく、まずAIによる回答が返ってきて、その上で様々な情報をマルチメディアで深堀りしていける検索画面になるそうです。

まずは海外で検証されてこれが上手くワークすれば世界的に展開されることでしょう!

こうなるとGoogleからのSEO流入は大きく減ることになり、SEOだけに頼っている事業者は結構まずいことになりそうな予感がします。

Google開発のLLMであるPaLM・PaLM2 まとめ

ここまでで、Google開発のLLMであるPaLM・PaLM2についてまとめてきました!

LLMについてある程度理解した後は各種モデルを具体的に手を動かしながら実装してみることが大事です。

各種大規模言語モデル(LLM)をPythonで利用する方法を知りたい方は当メディアが運営するスタアカの以下のコースを是非チェックしてみてください!

スタアカは業界最安級のAIデータサイエンススクールです。

| 【価格】 | ライトプラン:1280円/月 プレミアムプラン:149,800円 |

|---|---|

| 【オススメ度】 | |

| 【サポート体制】 | |

| 【受講形式】 | オンライン形式 |

| 【学習範囲】 | データサイエンスを網羅的に学ぶ 実践的なビジネスフレームワークを学ぶ SQLとPythonを組みあわせて実データを使った様々なワークを行う マーケティングの実行プラン策定 マーケティングとデータ分析の掛け合わせで集客マネタイズ |

・BigQuery上でSQL、Google Colab上でPythonを使い野球の投球分析

・世界最大手小売企業のウォルマートの実データを用いた需要予測

・ビジネス・マーケティングの基礎を学んで実際の企業を題材にしたマーケティングプランの策定

・Webサイト構築してデータ基盤構築してWebマーケ×データ分析実践して稼ぐ

AIデータサイエンスを学んで市場価値の高い人材になりましょう!

データサイエンスやAIの勉強方法は以下の記事でまとめています。

ちなみに、あまり日本だとPaLMについて解説しているものがないのですが、海外だと以下の動画が分かりやすくて面白かったです。