テキストマイニングとは?活用事例や可視化方法をPythonを使って学んでいこう!

こんにちは!スタビジ編集部です!

今回はテキストマイニングについてその使われ方や具体的な活用事例を紹介していきます。

記事の後半では、実際にPythonを使って文章中の単語重要度の可視化をするやり方についても紹介します!

・テキストマイニングとは?

・テキストマイニングの基本概念

・分かりやすい可視化法(ワードクラウド)

・Pythonでの実装

以下の動画でも解説していますのであわせてチェックしてみてください!

目次

テキストマイニングとは?

まず初めに、テキストマイニングとは何なのか?について解説していきます。

ずばり、テキストマイニングは、「テキストデータから情報を抽出し、そのデータの特性やパターンを分析するための手法」です!

この手法は、機械学習の中の自然言語処理という技術と組み合わせて利用されます。

テキストマイニングによって、収集したテキストデータから機械が文脈を理解して傾向を掴み、最終的にビジネスに活かす施策に結びつけるのに役立ちます!

以下にテキストマイニングのメリットを3つ挙げてみます!

・高精度:大量のテキストデータから学習を行い、傾向を読み解くことが可能であるため、精度が期待できる

・高速:データの収集、集計、分析のプロセスを効率化できる

・人による分析のデメリット解消:時間的効率以外にも、分析の属人化を防ぐだけでなく、文章を読むだけでは得られない情報の取得が可能

テキストマイニングは、昨今ますます重要性を増しているデータ解析手法です。

活用事例などについては後ほどご紹介します!

テキストマイニングのアプローチには、さまざまな手法や技術が利用されます。

テキストデータは、通常、人間が理解できる自然言語で書かれています。

このような非構造化データから有用な情報を抽出するために、テキストマイニングでは自然言語処理が広く利用されています。

自然言語処理でできることの紹介や、形態素解析・トピック分析などを実装しているこちらの記事もぜひご覧ください!!

テキストマイニングの基本概念と可視化手法

テキストマイニングの基本概念には、テキストデータの前処理・トークン化・単語の頻度分析・TF-IDFなどがあります!

テキストデータの前処理では、テキストデータのクリーニングやストップワードの削除などが行われます。

※ストップワード:「てにをは」や「andやor」などのように、頻繁に現れテキスト検索処理に関連する内容を持たないワード

これらの処理は、テキストデータからノイズを取り除き、解析の精度を向上させるために重要です!

テキストデータの前処理が完了したら、テキストデータをトークン化します。

トークン化は、テキストデータを単語やフレーズなどの小さな単位に分割するプロセスです。

テキストデータから単語の出現頻度を計算し、頻度分析を行うことで、テキストデータの特性やトレンドを理解することができます!

TF-IDF(Term Frequency-Inverse Document Frequency)

TF-IDF(Term Frequency-Inverse Document Frequency)は、テキストデータ内の単語の重要性を評価するための統計的手法です。

TF-IDFは、単語の出現頻度(TF)と逆文書頻度(IDF)の積で計算されます。

※逆文書頻度:ある単語がいくつの文書で使われているか

TFはある単語が特定の文書内でどれだけ頻繁に現れるかを示し、IDFはその単語がテキストデータ全体でどれだけ一般的であるかを示します。

1.TFの計算

特定の単語の出現頻度を計算します。文書内におけるその単語の出現回数をその文書の全単語数で割ることで、TFを計算します。

2.IDFの計算

特定の単語の逆文書頻度を計算します。全文書数をその単語が出現する文書数で割り、その値の対数を取ります。

3.TF-IDFの計算

TFとIDFの積を計算します。TFとIDFの値を掛け合わせることで、特定の単語の重要性を評価するTF-IDFスコアを得ることができます。

この、TF-IDFの計算を使ってテキストの類似度を実際に算出している以下の記事も合わせてご活用ください!

ワードクラウド

TF-IDFのロジックを使ったうえで視覚的に分かりやすくその重要度を文字の大きさで表したものがワードクラウドです!

言葉で説明するより見た方がとってもイメージしやすいです。

ずばり、以下のようなものです!

こんな感じのものを目にしたことがある方もいるのではないでしょうか!

このワードクラウドを使用するメリットとしては先程ご説明した「視覚的に分かりやすい」につきますが、細分化すると以下が言えるかもしれません。

・重要なトピックを特定:重要なトピックやキーワードを一目で見逃さずに抽出することができ、情報を素早く理解できる

・可視化による効果的コミュニケーション:非専門家や一般の人々にも理解しやすく、プレゼンや報告書で情報を効果的に伝えられる

・要約として活用:大量のテキストデータを要約して表現するための有用なツールとしても利用され、全体情報の概要サマリーを簡潔に把握できる

テキストマイニングの具体事例

テキストマイニングが実際にどのような場面で活用されているか?

イメージしやすい具体例を3つご紹介します!

ソーシャルメディアの感情分析

ソーシャルメディアは、世界中のユーザーが日常的に利用するコミュニケーションツールとして今もなお急速に普及しています!

TwitterやFacebookなどのプラットフォームでは、ユーザーが自分の意見や感情をテキストや画像、動画などの形で発信しています。

これらのソーシャルメディアの投稿から感情を抽出し、分析することを「感情分析」と呼びます!

テキストマイニングを用いた感情分析では、大量のソーシャルメディアの投稿からユーザーの感情や意見を把握し、製品やサービスに対する評判やブランドのイメージを分析することが可能です。

これにより、企業は顧客のニーズや要望を把握し、商品やサービスの改善やマーケティング戦略の改善に活かすことができます!

商品レビューの分析

近年、オンラインショッピングの普及に伴い、多くの消費者が商品のレビューや評価を参考に購買行動を行っています。

このような現状において、企業は商品レビューから有益な情報を抽出し、製品改善やマーケティング戦略の策定に役立てることが重要です。

テキストマイニングを用いることで、大量の商品レビューデータから特定の製品やブランドに関する意見やポジティブ・ニュートラル・ネガティブ感情を分析し、傾向や優先順位を把握することが可能です!

例えば、顧客が製品の特定の機能や品質に対してどのような評価をしているかを把握することで、具体的な施策アイディア出し等による製品改善、マーケティング戦略の最適化につながります。

ニュース記事のトピック分類

ニュースメディアは、世界中の出来事や情報を広く伝える重要な役割を果たしています。

しかし、膨大な数のニュース記事を効率的に分類し、特定のトピックに関連する記事を抽出することは容易ではありません。

テキストマイニングを用いたニュース記事のトピック分類では、自然言語処理技術や機械学習アルゴリズムを活用して、ニュース記事を自動的に分類することが可能です!

これにより、特定のトピックに関連するニュース記事を効率的に抽出し、情報の整理や分析を行うことができます。

例えば、政治、経済、スポーツ、エンターテイメントなどの様々なトピックに関連するニュース記事を分類することで、特定の分野に関する情報を簡単に見つけられます!

自分の分類したい切り口を設定したり、特定の分野を除外して表示させないようにしたりなどといったカスタマイズもテキストマイニングにより容易に行うことが出来ます!

トピック分析に関しては以下の記事で解説しています!

Pythonによる実装

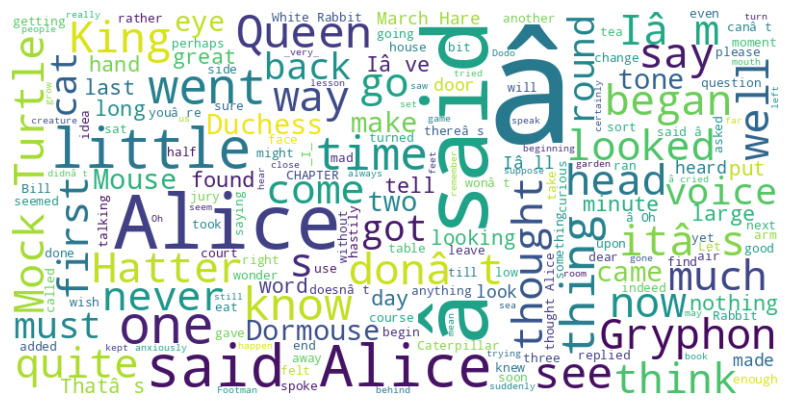

ここからは、実際のワードクラウドの手法をPython上で実装していきます!

今回はオンライン上の書籍、「不思議の国のアリス」の英語版を題材にワードクラウドを作成してみます。

以下の流れで進めます。

1. 必要なライブラリのインポート

2. URLを指定してオンライン上からテキストデータを取得

3. ワードクラウドを生成、表示させる

1. 必要なライブラリのインポート

まずはじめに必要なライブラリをインポートしてあげましょう。

可視化に用いるmatplotlibやWordCloudをインポートしていきます!

# 必要なライブラリのインポート

import requests

from wordcloud import WordCloud

import matplotlib.pyplot as plt2.URLを指定してオンライン上からテキストデータを取得

続いて、テキストデータの入ったURLを指定し、URLからテキストを取得させます。

例として下記に示したURLを指定していますが、ご自身で気になった文書があればそれに置き換えてみましょう!

# オンラインのテキストデータのURLを指定

url = "https://www.gutenberg.org/files/11/11-0.txt" # 例としてプロジェクト・グーテンベルクの『不思議の国のアリス』のURLを使用

# URLからテキストを取得

response = requests.get(url)

text = response.text3. ワードクラウドを生成、表示させる

最後に取得したテキストデータを下にワードクラウドを生成し、出力させていきます!

# ワードクラウドを生成する

wordcloud = WordCloud(width=800, height=400, background_color="white").generate(text)

# ワードクラウドを表示する

plt.figure(figsize=(10, 5))

plt.imshow(wordcloud, interpolation="bilinear")

plt.axis("off")

plt.show()

plt.show() による実際の出力結果を見てみましょう。

無事、ワードクラウドが出力されました!!

重要度の高い単語は大きく、低い単語はかなり小さくといった形で分かりやすく可視化をすることが出来ました!

テキストマイニングまとめ

ここまでご覧いただきありがとうございました!

本記事では、テキストマイニングの概念と分かりやすい可視化の方法についてまとめました!

単語の重要度を計算から測定するTF-IDFが重要な考え方でしたね!

そしてワードクラウドにより視覚的に理解しやすい画像データに変換することが可能でした。

ワードクラウドでは、形を猫にしたりなど外枠の形を四角じゃないものに変更することも可能です。

ぜひ一度文章を抜き出して単語の重要度を可視化してみてください!

このようなデータサイエンスの力を身に付けるためにはスタビジの記事やスクールを活用すると良いでしょう。

そして僕の経験を詰め込んだデータサイエンス特化のスクール「スタアカ(スタビジアカデミー)」を運営していますので,興味のある方はぜひチェックしてみてください!

AIデータサイエンス特化スクール「スタアカ」

| 【価格】 | ライトプラン:1280円/月 プレミアムプラン:149,800円 |

|---|---|

| 【オススメ度】 | |

| 【サポート体制】 | |

| 【受講形式】 | オンライン形式 |

| 【学習範囲】 | データサイエンスを網羅的に学ぶ 実践的なビジネスフレームワークを学ぶ SQLとPythonを組み合わせて実データを使った様々なワークを行う マーケティングの実行プラン策定 マーケティングとデータ分析の掛け合わせで集客マネタイズ |

データサイエンティストとしての自分の経験をふまえてエッセンスを詰め込んだのがこちらのスタビジアカデミー、略して「スタアカ」!!

当メディアが運営するスクールです。

24時間以内の質問対応と現役データサイエンティストによる複数回のメンタリングを実施します!

カリキュラム自体は、他のスクールと比較して圧倒的に良い自信があるのでぜひ受講してみてください!

他のスクールのカリキュラムはPythonでの機械学習実装だけに焦点が当たっているものが多く、実務に即した内容になっていないものが多いです。

そんな課題感に対して、実務で使うことの多いSQLや機械学習のビジネス導入プロセスの理解なども合わせて学べるボリューム満点のコースになっています!

Pythonが初めての人でも学べるようなカリキュラムにしておりますので是非チェックしてみてください!

ウォルマートのデータを使って商品の予測分析をしたり、実務で使うことの多いGoogleプロダクトのBigQueryを使って投球分析をしたり、データサイエンティストに必要なビジネス・マーケティングの基礎を学んでマーケティングプランを作ってもらったり・Webサイト構築してデータ基盤構築してWebマーケ×データ分析実践してもらったりする盛りだくさんの内容になってます!

・BigQuery上でSQL、Google Colab上でPythonを使い野球の投球分析

・世界最大手小売企業のウォルマートの実データを用いた需要予測

・ビジネス・マーケティングの基礎を学んで実際の企業を題材にしたマーケティングプランの策定

・Webサイト構築してデータ基盤構築してWebマーケ×データ分析実践して稼ぐ

データサイエンスに関する記事はこちら!

データサイエンスを勉強できるスクールやサイトは、ぜひこちらを参考にしてみてください!